Inteligência artificial ‘anti-trapaça’ acusa aluno de trapacear durante exame e especialistas alegam outros problemas por trás da tecnologia.

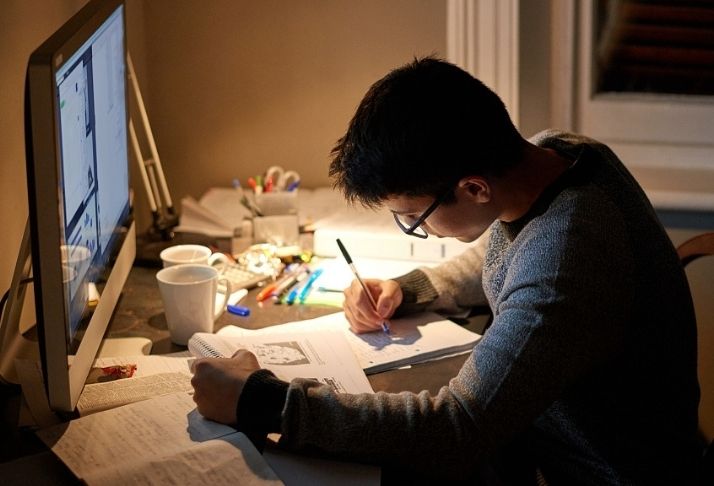

Atualmente, é difícil dizer se um aluno está trapaceando durante um exame, uma vez que as aulas já são realizadas on-line por causa da pandemia. Para ajudar os professores a monitorar adequadamente seus alunos, foi desenvolvido um software “anti-batota”.

As escolas podem confiar nessa nova inteligência artificial?

A ProctorU, o programa de fiscalização de exames, já acusou uma estudante universitária de trapacear durante um exame. A estudante, com o nome de usuário DaynuhJoe, publicou sua reação no TikTok.

A inteligência artificial assinalou como suspeitos alguns de seu comportamento durante um exame. Por causa do relatório da ProctorU, seu professor decidiu dar a ela um zero na avaliação.

“Então, só para que você saiba como está indo a escola e a faculdade on-line, acabei de fazer um exame para o qual estudei muito, muito duro, e obtive um B nele. E é um exame bastante difícil, então um B é muito bom”, disse ela.

“E meu professor está me dando um zero, porque o Review+ disse que eu estava falando quando eu estava apenas, tipo, relendo a pergunta para que eu pudesse entendê-la melhor”, acrescentou ela.

O vídeo ficou viral em menos de uma semana, recebendo 3 milhões de visualizações. Os espectadores apoiaram a menina na seção de comentários e condenaram o professor por sua ação.

Um dos usuários do TikTok disse que lamentava muito que o estudante tivesse que lidar com a situação.

Outros desafios dessa tecnologia

DaynuhJoe não é a única aluno afetado pela nova tecnologia.

O software de fiscalização também está causando problemas para outros estudantes por causa da cor da pele. Outro estudante chamado Alivardi Khan disse que o ExamSoft, uma ferramenta de monitoramento utilizada durante o exame da Ordem, não consegue reconhecê-lo por causa da baixa iluminação.

Leia também: YouTube traz de volta moderadores humanos após censura dos sistemas de inteligência artificial

O estudante disse que ele está bastante seguro de que todos os estudantes já previram que o software não funcionaria para pessoas de outras etnias ou com cores de pele diferentes.

Este tipo de tecnologia já enfrentou críticas porque identifica erroneamente as pessoas, por causa da cor de sua pele ou sua etnia.

O Instituto Nacional de Padrões e Tecnologia (NIST) realizou um estudo em 2019 e descobriu que a tecnologia de reconhecimento facial geralmente não identifica asiáticos e afro-americanos.

Traduzido e adaptado por equipe Revolução.etc.br

Fontes: Tech Times, Instituto Nacional de Padrões e Tecnologia (NIST),